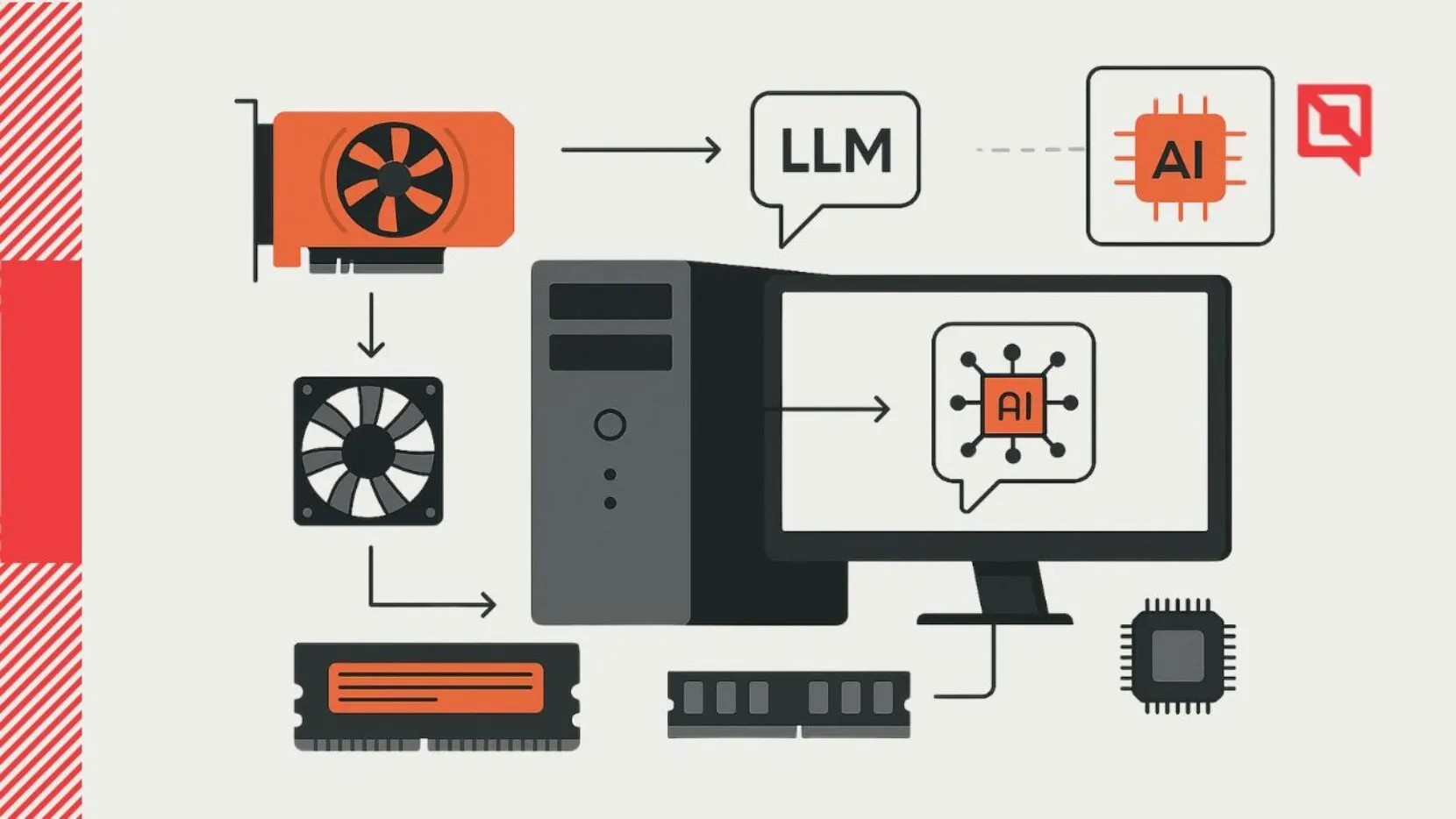

De hardware achter het lokaal draaien van een LLM

In dit tweede deel van onze blogserie over het lokaal draaien van een Large Language Model (LLM), gaan we in op de hardware. Spoiler: het is geen high-end AI-cluster, maar juist een budgetvriendelijke en verrassend leerzame opstelling. Deel 1 van deze serie lees je hier.

Welke hardware gebruik je voor het lokaal draaien van een LLM?

Bij Divtag hebben we geen LLM gebouwd of getraind. We draaien bestaande open source LLM’s van andere partijen – zoals Mistral, LLaMA of Phi – lokaal, op een budget-pc.

Onze setup:

- Een desktop-pc uit standaardcomponenten

- Een oude datacenter GPU (een zogenaamde compute kaart)

- Geen exotische hardware, geen liquid cooling, geen duizenden euro’s

Ons doel was niet maximale performance, maar maximale leercurve. We wilden gewoon zelf aan de slag met lokaal draaien van taalmodellen – en dat kan dus prima met relatief eenvoudige hardware.

Waarom deze componenten?

Voor het lokaal draaien van taalmodellen heb je vooral twee dingen nodig: veel RAM en een GPU die goed is in parallelle rekentaken. Taalmodellen zijn intensief en draaien efficiënter op GPU’s dan op standaard CPU’s.

Op basis van communitytips en online bronnen kwamen we uit bij een NVIDIA Tesla M40 – een datacenterkaart met 24GB RAM, die je tegenwoordig voor ongeveer €200 tweedehands kunt vinden. Dat maakte het een interessante budgetoptie voor onze leerdoelen.

📄 Bekijk de specificaties van de Tesla M40 (PDF)

De rest van de setup hebben we eromheen gebouwd. Niet omdat we deze kaart al hadden liggen, maar omdat dit een van de beste prijs-prestatiekeuzes is voor wie met open source LLM’s wil experimenteren zonder direct duizenden euro’s uit te geven.

Welke uitdagingen kwamen jullie tegen?

De enige echte uitdaging? Koeling.

De GPU is gemaakt voor datacentergebruik met luchtstromen van industriële serverracks. In een normale kast wordt hij snel te warm. We hebben dus moeten improviseren met extra ventilatoren om de temperatuur binnen de perken te houden.

Wat kost zo’n setup?

Onze totale setup kostte ongeveer €1.000. Daarmee draaien we modellen die ongeveer tien keer kleiner zijn dan de GPT-klasse modellen in de cloud. Een vergelijking met commerciële cloudoplossingen gaat dus mank – we draaien andere modellen, met een ander doel.

Voor ons was dit vooral een leertraject. Geen schaalbare oplossing voor eindgebruikers, maar een hands-on manier om ervaring op te doen met LLM’s buiten de black box van een API.

Is het schaalbaar?

Nee.

We kunnen hier geen grote modellen op draaien, en de setup is niet bedoeld voor productie of meerdere gebruikers tegelijk. Sterker nog: een MacBook met 64GB RAM kan in sommige gevallen méér aan dan onze pc. Maar dat was ook niet het doel.

Waarom dan toch?

Omdat we het zelf wilden begrijpen. LLM’s lokaal draaien is leerzaam, leuk, en helpt je écht snappen hoe alles werkt – van modelkeuze tot GPU-memory, quantization en latency.

Dit was deel 2 van onze blogserie over het lokaal draaien van een LLM. In deel 3 gaan we dieper in op welke software we gebruiken om LLM’s lokaal te kunnen draaien met onze setup.