De software achter het lokaal draaien van een LLM

Inleiding

Steeds meer bedrijven experimenteren met Artificial Intelligence (AI), en met name Large Language Models (LLM’s) zoals ChatGPT of Claude. Maar wie echt controle wil over data, snelheid en toepassingen, kiest ervoor om een LLM lokaal te draaien. Bij Divtag zijn we dit avontuur aangegaan met een duidelijke reden: maximale grip op privacy en maximale vrijheid om te leren. In deel 1 van onze blogserie legden we uit waarom we een LLM lokaal draaien. In deel 2 gingen we in op de hardware.

In dit derde deel vertellen we alles over de software achter het lokaal draaien van een LLM. Welke tools gebruiken we? Wat zijn de uitdagingen? En hoe zorgen we voor veilige toegang?

Onze softwarestack: eenvoudig en effectief

Bij het lokaal draaien van een LLM is je softwarestack net zo belangrijk als je hardware. Wij hebben gekozen voor een combinatie van open source tools die betrouwbaar, actief onderhouden en goed gedocumenteerd zijn.

Ollama als motor onder de motorkap

Ollama is het hart van onze setup. Deze tool maakt het mogelijk om LLM’s lokaal te draaien op relatief eenvoudige hardware. Ollama ondersteunt meerdere modellen en heeft een gebruiksvriendelijke interface via de command line. Bovendien werkt het goed samen met quantized modellen (zoals GGUF-formaten), wat essentieel is voor draaien op betaalbare GPU’s.

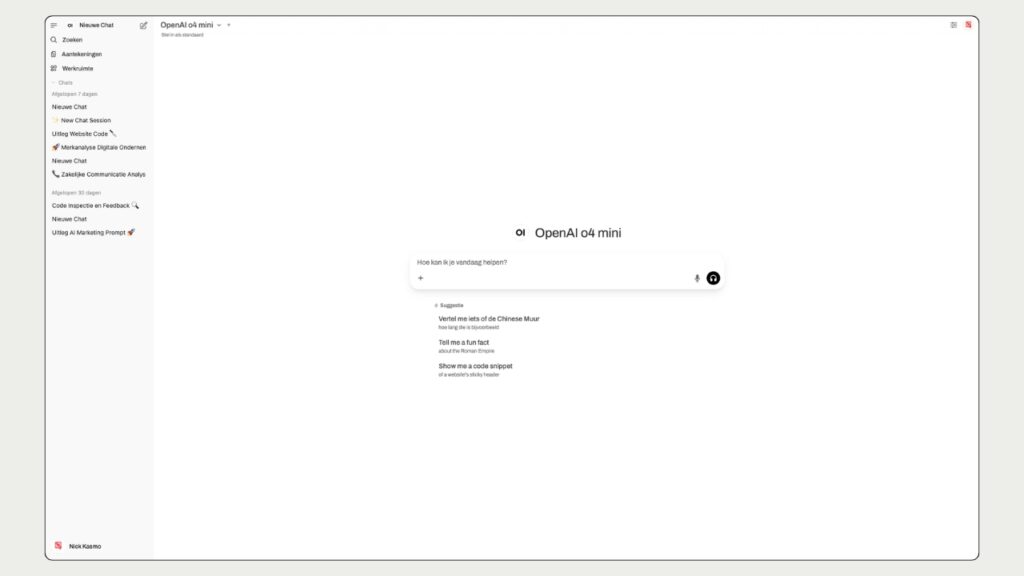

Open WebUI als gebruikersinterface

Voor collega’s die liever klikken dan coderen, gebruiken we Open WebUI als frontend. Hiermee kun je lokaal vragen stellen aan het model via een browserinterface. Dit verlaagt de drempel voor niet-developers en maakt het testen van prompts eenvoudiger.

Programmeertalen en libraries

Achter de schermen draait veel van de software op Python en C++, maar in onze eigen maatwerktoepassingen gebruiken we ook PHP. Met behulp van de Prism Library bouwen we eenvoudige integraties en visualisaties.

Dit stelt ons in staat om LLM-functionaliteit naadloos te koppelen aan bestaande systemen en projecten zonder telkens het wiel opnieuw uit te vinden.

Beveiliging: lokaal maar niet vrijblijvend

Een lokaal draaiend taalmodel klinkt misschien als een vrijbrief om los te gaan, maar veiligheid blijft cruciaal. We hebben meerdere maatregelen genomen om toegang tot de LLM te beperken:

- De LLM is volledig afgesloten van het internet.

- De WebUI is alleen intern bereikbaar en vereist authenticatie.

- Alleen bevoegde gebruikers krijgen toegang tot het systeem.

Hiermee zorgen we ervoor dat gevoelige gegevens nooit buiten ons netwerk terechtkomen, en dat alleen geautoriseerde teamleden toegang hebben tot de modellen.

Uitdagingen en oplossingen

Zoals bij elk technisch project liepen we tegen de nodige uitdagingen aan. De grootste? De razendsnelle ontwikkeling van nieuwe modellen. Soms ontdekten we dat een model dat we wilden testen niet werkte met onze versie van Ollama, omdat het model een nieuwer GGUF-formaat gebruikte.

Onze oplossing:

- Regelmatig controleren op updates van Ollama.

Wat we nog willen ontwikkelen

Op dit moment gebruiken we voornamelijk standaardtools en configuraties. Maar onze plannen gaan verder:

- We willen eenvoudige koppelingen maken waarmee de uitkomst van het taalmodel direct gebruikt kan worden in software voor klanten.

- Daarnaast werken we aan tools die ook te gebruiken zijn door collega’s zonder technische kennis.

- Ook willen we een interne kennisbank ontwikkelen waarin alle belangrijke informatie over ons bedrijf staat. Collega’s kunnen daar eenvoudig vragen stellen en direct antwoord krijgen, bijvoorbeeld over processen, tools of klantprojecten. Zo maken we kennis beter toegankelijk voor iedereen.

Deze uitbreidingen zorgen ervoor dat we AI niet alleen gebruiken, maar ook slimmer maken met de input van ons team.

Conclusie: begin klein, leer veel

De software achter het lokaal draaien van een LLM hoeft niet complex of kostbaar te zijn. Met tools als Ollama en Open WebUI kun je snel aan de slag. Combineer dat met de juiste beveiliging en regelmatige updates, en je hebt een krachtige omgeving om te experimenteren met AI.

Wil jij zelf een LLM lokaal draaien? Begin met een klein model en test je setup. Zo ontdek je snel waar je behoeften liggen – en welke tools daar het beste bij passen.

"*" geeft vereiste velden aan

Meer weten over hoe wij dit aanpakken? Lees deel 1 en deel 2 van deze serie, of neem contact op voor een demo.